Meta ha annunciato che i ricercatori di intelligenza artificiale (AI) e gli specialisti audio del team di Reality Labs stanno lavorando a tre nuovi elementi audio per la comprensione audiovisiva delle esperienze virtuali. Questi elementi per esperienze virtuali sono progettati per spingerci verso una realtà più immersiva a un ritmo più veloce.

Tre nuovi modelli per le esperienze virtuali

I tre nuovi modelli di intelligenza artificiale sono stati progettati per rendere il suono più realistico nelle esperienze di realtà mista e virtuale. Tutti e tre i modelli si collegano alla ricerca sull’intelligenza artificiale sulla percezione audiovisiva. Lo scopo di Meta, infatti, è quello di creare un’esperienza, per chi indossa occhiali AR, che lo faccia sentire immerso non solo dalla grafica ma anche dai suoni.

Visual-Acoustic Matching

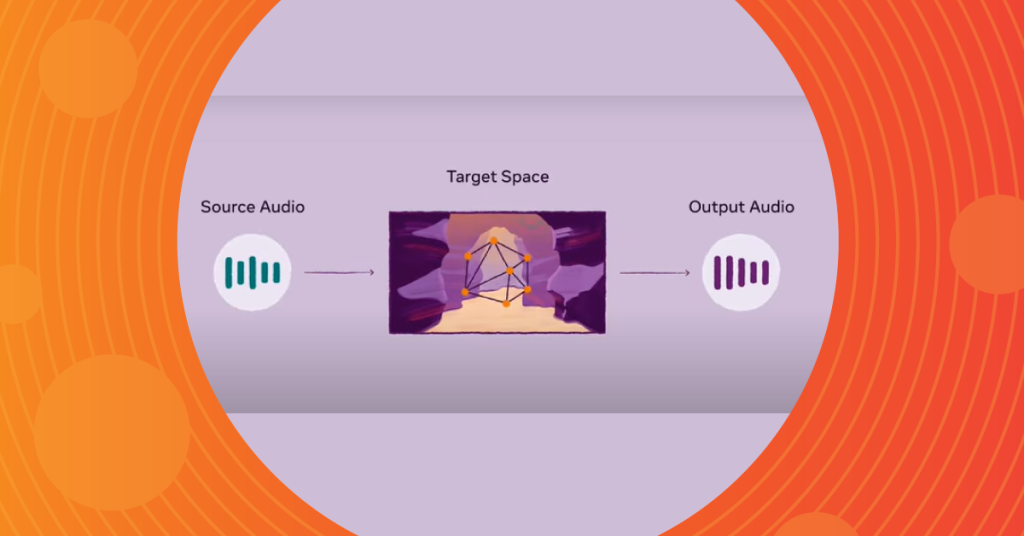

Questo modello, chiamato AViTAR, regola l’audio in modo che corrisponda ad una precisa immagine. Chiunque abbia visto un video in cui l’audio non è coerente con la scena sa quanto questo possa essere fastidioso. Viene quindi utilizzato un modello di trasformatore cross-modale, in cui gli input sono costituiti sia da immagini che da audio, consentendo al trasformatore di eseguire ragionamenti sull’intermodalità e generare un’uscita audio realistica che corrisponde all’input visivo. Un caso d’uso futuro riguarda il rivivere i ricordi passati. Indossando gli occhiali AR si potrebbe vedere un oggetto con la possibilità di riprodurre un ricordo ad esso associato.

Visually-Informed Deverberation

Utilizzando i suoni e i segnali visivi di uno spazio, questo modello si concentra sulla rimozione del riverbero, ovvero l’eco che un suono fa in base all’ambiente in cui è registrato. Immaginiamo un concerto di violino in una stazione ferroviaria affollata. Questo modello può eliminare i riverberi della stazione ferroviaria, lasciando solo l’essenza della musica del violinista. In certi casi, infatti, rimuovere il riverbero è necessario per migliorare l’udito e la comprensione. Questo potrebbe essere utile, per esempio, per le persone con perdita dell’udito.

VisualVoice

Uno dei motivi per cui le persone sono più brave dell’IA nel comprendere il parlato in contesti complessi è che noi non usiamo solo le nostre orecchie ma anche i nostri occhi. Questo terzo modello apprende in maniera simile al modo in cui le persone acquisiscono nuove abilità: comprende il parlato guardando oltre che ascoltando. Il modello VisualVoice utilizza segnali visivi e audio per separare il parlato da altri suoni e voci di sottofondo. Questo potrebbe essere utile per attività di comprensione umana e meccanica, come creare sottotitoli migliori o socializzare a una festa in VR.

Il futuro delle esperienze virtuali

In futuro, Meta mira a creare modelli in grado di acquisire segnali audio, video e di testo contemporaneamente e creare una comprensione molto più ricca dell’ambiente. L’obiettivo è creare un’IA multimodale che comprenda gli ambienti del mondo reale e il modo in cui le persone li vivono.

Il raggiungimento di questo futuro passa anche dalla realizzazione di visori che puntano a garantire un’esperienza d’uso che sia vivida e realistica come il mondo reale. Proprio poche settimane fa la Meta Reality Labs ha svelato dei nuovi prototipi di visori che puntano a una grafica di realtà virtuale leggera e iperrealistica.